اختبار تورنگ

| جزء من سلسلة عن |

| الذكاء الاصطناعي |

|---|

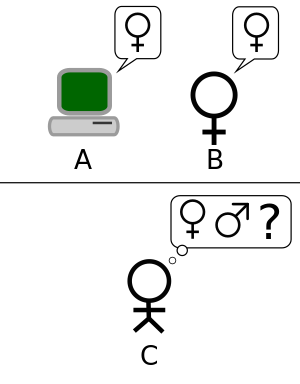

اختبار تورنگ Turing test، الذي أطلق عليه في الأصل لعبة التقليد imitation game بقلم آلان تورنگ في عام 1950،[2] هو اختبار لقدرة الآلة على إظهار سلوك ذكي مكافئ أو لا يمكن تمييزه عن الإنسان. اقترح تورنگ أن المقيِّم البشري سيحكم على محادثات اللغة الطبيعية بين الإنسان والآلة المصممة لتوليد استجابات شبيهة بالبشر. سيكون المقيِّم على دراية بأن أحد الشريكين في المحادثة عبارة عن آلة، وسيتم فصل جميع المشاركين عن بعضهم البعض. ستقتصر المحادثة على قناة نصية فقط مثل لوحة مفاتيح الحاسب والشاشة، لذا لن تعتمد النتيجة على قدرة الجهاز على تحويل الكلمات إلى كلام.[3]إذا لم يتمكن المقيّم من إخبار الآلة عن الإنسان بشكل موثوق، يُقال إن الآلة قد اجتازت الاختبار. لا تعتمد نتائج الاختبار على قدرة الآلة على إعطاء إجابات على الأسئلة صحيحة، فقط مدى تشابه إجاباتها مع تلك التي يقدمها الإنسان.

تم تقديم الاختبار بواسطة تورنگ في ورقته البحثية عام 1950، "آلات الحوسبة والذكاء"، أثناء عمله في جامعة مانشستر (تورنگ، 1950; p. 460).[4] يبدأ بالكلمات: "أقترح النظر في السؤال،" هل تستطيع الآلات التفكير؟'" نظرًا لصعوبة تحديد "التفكير"، يختار تورنگ "استبدال السؤال بآخر وثيق الصلة به ويتم التعبير عنها بكلمات لا لبس فيها نسبياً. "[5] يصف تورنگ الشكل الجديد للمشكلة من منظور لعبة من ثلاثة أشخاص تسمى لعبة التقليد، حيث يسأل المحقق أسئلة لرجل وامرأة في غرفة أخرى من أجل تحديد الجنس الصحيح للاعبين. سؤال تورنگ الجديد هو: "هل هناك حواسيب رقمية يمكن تخيلها ستعمل بشكل جيد في لعبة التقليد؟"[2] يعتقد تورنگ أن هذا السؤال يمكن الإجابة عليه بالفعل. في الجزء المتبقي من الورقة، جادل ضد جميع الاعتراضات الرئيسية على الافتراض القائل بأن "الآلات يمكنها التفكير".[6]

منذ أن قدم تورنگ اختباره لأول مرة، فقد ثبت أنه مؤثر للغاية ومنتقد على نطاق واسع، وأصبح مفهوماً مهماً في فلسفة الذكاء الاصطناعي.[7][8][9].بعض هذه الانتقادات، مثل الغرفة الصينية لجون سيرل، مثيرة للجدل في حد ذاتها.

تاريخ

الخلفية الفلسفية

إن مسألة ما إذا كان من الممكن للآلات أن تفكر لها تاريخ طويل، وهو راسخ بقوة في التمييز بين الثنائية و المادية للعقل. يرسم رينيه ديكارت جوانب اختبار تورنگ في كتابه عام 1637 خطاب حول الطريقة عندما كتب:

[ك]يف يمكن صنع العديد من الآلات أو الآلات المتحركة المختلفة بواسطة صناعة الإنسان ؛ ... لأننا نستطيع بسهولة أن نفهم تكوين الآلة بحيث يمكنها نطق الكلمات ، وحتى إصدار بعض الاستجابات لفعل من النوع المادي، مما يؤدي إلى حدوث تغيير في عناصرها؛ على سبيل المثال، إذا تم لمس جزء معين، فقد يسأل عما نرغب في قوله له؛ إذا كان قد يصيح في جزء آخر بأنه مصاب، وهكذا. لكن لم يحدث أبداً أنها تنظم حديثها بطرق مختلفة، من أجل الرد بشكل مناسب على كل ما يمكن أن يقال في حضورها، كما يفعل حتى أدنى نوع من البشر..[10]

هنا لاحظ ديكارت أن الآلة ذاتية الحركة قادرة على الاستجابة للتفاعلات البشرية، لكنه جادل بأن مثل هذه الآلة لا يمكنها الاستجابة بشكل مناسب للأشياء التي يقال في وجودها بالطريقة التي يستطيع أي إنسان. لذلك، صور ديكارت اختبار تورنگ عن طريق تحديد عدم كفاية الاستجابة اللغوية المناسبة على أنها تلك التي تفصل الإنسان عن الإنسان الآلي. وفشل ديكارت في النظر في إمكانية أن تكون هذه الآلة المستقبلية قادرة على التغلب على هذا القصور، وبالتالي لا يقترح اختبار تورنگ على هذا النحو، حتى لو كان يصور مسبقاً إطارها المفاهيمي ومعيارها.

صاغ دينيس ديدرو في أفكار فلسفية Pensées philosophiques معيار اختبار تورنگ:

"إذا وجدوا ببغاءً يمكنه الرد على كل شيء، فسأدعي أنه كائن ذكي دون تردد."[11]

هذا لا يعني أنه يوافق على هذا، لكنه كان بالفعل حجة شائعة للماديين في ذلك الوقت.

وفقاً للثنائية، فإن العقل غير مادي (أو، على الأقل، لديه الخصائص غير المادية)[12] وبالتالي، لا يمكن تفسيرها من الناحية المادية البحتة. وفقاً للمادية، يمكن تفسير العقل مادياً، مما يترك إمكانية العقول التي يتم إنتاجها بشكل مصطنع مفتوحة.[13]

في عام 1936، نظر الفيلسوف ألفريد آير في السؤال الفلسفي القياسي عن عقول أخرى: كيف نعرف أن الآخرين لديهم نفس التجارب الواعية التي نمتلكها؟ في كتابه اللغة والحقيقة والمنطق، اقترح آير پروتوكولًا للتمييز بين الإنسان الواعي والآلة اللاواعية: "الأساس الوحيد الذي يمكنني الحصول عليه لتأكيد أن الشيء الذي يبدو واعياً ليس في الحقيقة كائناً واعياً، ولكن فقط دمية أو آلة، هو أنه يفشل في تلبية أحد الاختبارات التجريبية التي يتم من خلالها تحديد وجود أو غياب الوعي."[14] (هذا الاقتراح مشابه جداً لاختبار تورنگ، لكنه يهتم بالوعي أكثر من الذكاء. علاوة على ذلك، ليس من المؤكد أن الكلاسيكية الفلسفية الشهيرة لآير كانت مألوفة لتورنگ). وبعبارة أخرى، لا يكون الشيء واعياً إذا فشل في اختبار الوعي.

آلان تورنگ

كان الباحثون في المملكة المتحدة يستكشفون "الذكاء الآلي" لمدة تصل إلى عشر سنوات قبل تأسيس مجال الذكاء الاصطناعي ( AI) في عام 1956.[15] كان موضوعاً شائعاً بين أعضاء نادي ريشيو، وهي مجموعة غير رسمية من الباحثين البريطانيين لعلم التحكم الآلي و الإلكترونيات من بينهم آلان تورنگ.[16]

فقد كان تورنگ، على وجه الخصوص، يتعامل مع فكرة ذكاء الآلة منذ عام 1941 على الأقل[17] وكان أحد أقدم الإشارات المعروفة لـ "ذكاء الحاسب" عام 1947.[18] في تقرير تورنگ، "الآلات الذكية"،[19]لقد قام بالتحقيق في "مسألة ما إذا كان من الممكن للآلات أن تظهر سلوكاً ذكياً أم لا" [20]، وكجزء من هذا التحقيق، اقترح ما يمكن اعتباره سلفاً لما بعده الاختبارات:

ليس من الصعب ابتكار آلة ورقية ستلعب لعبة ليست سيئة للغاية من ألعاب الشطرنج.[21] الآن احصل على ثلاثة رجال كمواضيع للتجربة. يجب أن يكون A و B و C. A و C لاعبي شطرنج بسطاء إلى حد ما، B هو العامل الذي يعمل في آلة الورق. ... يتم استخدام غرفتين مع بعض الترتيبات لتوصيل الحركات، ويتم لعب لعبة بين C وإما A أو آلة الورق. قد يجد C صعوبة بالغة في معرفة من يلعب.[22]

"آلات الحوسبة والذكاء" (1950) كانت أول ورقة منشورة بواسطة تورنگ والتي تركز بشكل حصري على ذكاء الآلة. بدأ تورنگ مقالة عام 1950 بالادعاء، "أقترح النظر في السؤال" هل يمكن للآلات أن تفكر؟'"[5] كما أوضح، فإن النهج التقليدي لمثل هذا السؤال هو أن تبدأ بـ تعريفات، وتعريف كلا من المصطلحين "آلة" و "ذكاء". يختار تورنگ عدم القيام بذلك؛ بدلاً من ذلك، استبدل السؤال بسؤال جديد، "الذي يرتبط ارتباطاً وثيقاً به ويتم التعبير عنه بكلمات واضحة نسبياً."[5] في جوهره يقترح تغيير السؤال من "يمكن الآلات أن تفكر؟ " إلى "هل يمكن للآلات أن تفعل ما يمكننا (ككيانات تفكير) القيام به؟" [23] يرى تورنگ أن ميزة السؤال الجديد هي أنه يرسم "خطاً حاداً إلى حد ما بين القدرات الجسدية والفكرية للإنسان."[24]

لإثبات هذا النهج، يقترح تورنگ اختبارًا مستوحى من لعبة الفريق، والمعروفة باسم "لعبة التقليد"، حيث يذهب رجل وامرأة إلى غرف منفصلة ويحاول الضيوف التمييز بينهما عن طريق كتابة سلسلة من الأسئلة وقراءة الإجابات المكتوبة على الآلة الكاتبة أرسلت مرة أخرى. في هذه اللعبة، يهدف كل من الرجل والمرأة إلى إقناع الضيوف بأنهم الآخر. (يجادل هوما شاه بأن هذه النسخة المكونة من شخصين من اللعبة قد تم تقديمها بواسطة تورنگ فقط لتعريف القارئ باختبار أسئلة وأجوبة الإنسان الآلي. [25])) وصف تورنگ نسخته الجديدة من اللعبة على النحو التالي:

نسأل الآن السؤال، "ماذا سيحدث عندما تأخذ آلة الجزء A في هذه اللعبة؟" هل سيقرر المحقق خطأً في كثير من الأحيان عندما تُلعب اللعبة بهذه الطريقة كما يفعل عندما تُلعب اللعبة بين رجل وامرأة؟ هذه الأسئلة تحل محل أسئلتنا الأصلية، "هل تستطيع الآلات التفكير?"[24]

لاحقاً في الورقة البحثية يقترح تورنگ صيغة بديلة "مكافئة" تتضمن قاضياً يتحدث فقط مع حاسب ورجل. [26] بينما لا تتطابق أي من هذه الصيغ تماماً مع إصدار اختبار تورنگ وهو معروف اليوم بشكل أكثر عمومية، فقد اقترح نسخة ثالثة في عام 1952. في هذه النسخة، التي ناقشها تورنگ في بث إذاعي على BBC، تطرح هيئة المحلفين أسئلة حول الحاسب ويتمثل دور الحاسب في جعل نسبة كبيرة من هيئة المحلفين يعتقدون أنه حقاً رجل.[27]

نظرت ورقة تورنگ في تسعة اعتراضات مفترضة، والتي تتضمن جميع الحجج الرئيسية ضد الذكاء الاصطناعي التي أثيرت في السنوات التي تلت نشر الورقة (انظر "آلات الحوسبة والذكاء").[6]

إليزا وپاري

في عام 1966، أنشأ جوزيف ڤايزنباوم برنامجاً يبدو أنه اجتاز اختبار تورنگ. يعمل البرنامج، المعروف باسم إليزا، من خلال فحص تعليقات المستخدم المكتوبة بحثاً عن الكلمات الرئيسية. إذا تم العثور على كلمة أساسية، يتم تطبيق القاعدة التي تحول تعليقات المستخدم، ويتم إرجاع الجملة الناتجة. إذا لم يتم العثور على كلمة رئيسية، فإن إليزا يستجيب إما برد عام أو بتكرار أحد التعليقات السابقة.[28] بالإضافة إلى ذلك، طور ڤايزنباوم إليزا لتكرار سلوك المعالج النفسي روجريان، مما يسمح لـ إليزا بأن تكون "حرة في تحمل وضعية عدم معرفة أي شيء تقريبًا عن العالم الحقيقي."[29] باستخدام هذه التقنيات، تمكن برنامج ڤايزنباوم من خداع بعض الناس للاعتقاد بأنهم يتحدثون إلى شخص حقيقي، مع وجود بعض الأشخاص "من الصعب جدًا إقناع ELIZA [...]أنه ليس إنساناً"."[29]وبالتالي، يزعم البعض أن إليزا هو أحد البرامج (ربما الأول) القادرة على اجتياز اختبار تورنگ،[29][30] على الرغم من أن هذا الرأي مثير للجدل إلى حد كبير (انظر أدناه).

أنشأ كينيث كولبي پاري في عام 1972، وهو برنامج يوصف بأنه "إليزا ذو سلوك".[31] وحاولت صياغة نموذج لسلوك المصاب انفصام الارتياب، باستخدام نهج مشابه (وإن كان أكثر تقدماً) لتلك التي استخدمها ڤايزنباوم. للتحقق من صحة العمل، تم اختبار پاري في أوائل السبعينيات باستخدام نسخة مختلفة من اختبار تورنگ. قامت مجموعة من الأطباء النفسيين ذوي الخبرة بتحليل مجموعة من المرضى الحقيقيين وأجهزة الحاسب التي تشغل پاري من خلال طابعات عن بعد. وعرضت على مجموعة أخرى من 33 طبيباً نفسياً نصوصاً من المحادثات. ثم طُلب من المجموعتين تحديد أي من "المرضى" كان بشرًا وأيها كان برامج حاسب.[32] كان الأطباء النفسيون قادرين على تحديد الهوية الصحيحة في 48٪ فقط من الوقت – وهو رقم يتفق مع التخمين العشوائي.[33]

في القرن الحادي والعشرين، استمرت إصدارات هذه البرامج (المعروفة الآن باسم "تشاتر بوت) في خداع الناس. "سايبرلَڤر"، وهو من البرمجيات الخبيثة، يفترس مستخدمي الإنترنت من خلال إقناعهم بـ "الكشف عن معلومات حول هوياتهم أو توجيههم لزيارة موقع ويب يقدم محتوى ضاراً إلى أجهزة الحاسب الخاصة بهم".[34] برز البرنامج على أنه "خطر عيد الحب" يقوم بمغازلة الأشخاص "ساعياً إلى إقامة علاقات عبر الإنترنت من أجل جمع بياناتهم الشخصية".[35]

الغرفة الصينية

اقترحت ورقة جون سيرل العقول والأدمغة والبرامج تجربة فكرية "الغرفة الصينية" وجادل بأن اختبار تورنگ لا يمكن استخدامه لتحديد ما إذا كان يمكن للآلة أن تفكر. لاحظ سيرل أن البرامج (مثل ELIZA) يمكنها اجتياز اختبار تورنگ ببساطة عن طريق التلاعب بالرموز التي لا يفهمونها. بدون فهم، لا يمكن وصفهم بأنهم "يفكرون" بنفس إدراك البشر. لذلك، يستنتج سيرل، لا يمكن لاختبار تورنگ إثبات قدرة الآلة على التفكير. [36] مثل اختبار تورنگ نفسه، تعرضت حجة سيرل لانتقادات واسعة النطاق[37] وتمت مصادقته بشكل كبير للغاية.[38]

أشعلت الحجج مثل سيرل وغيره ممن يعملون على فلسفة العقل نقاشاً أكثر حدة حول طبيعة الذكاء، وإمكانية الآلات الذكية وقيمة اختبار تورنگ الذي استمر خلال الثمانينيات والتسعينيات.[39]

جائزة لوبنر

توفر جائزة لوبنر منصة سنوية لاختبارات تورنگ العملية مع المنافسة الأولى التي أقيمت في نوفمبر 1991. [40] تم إكتتابها بواسطة هيو لوبنر. نظم مركز كامبردج للدراسات السلوكية في ماساتشوستس بالولايات المتحدة الجوائز حتى مسابقة عام 2003 بما فيها. كما وصفها لوبنر، فإن أحد أسباب إنشاء المنافسة هو تعزيز حالة أبحاث الذكاء الاصطناعي، على الأقل جزئياً، لأنه لم يتخذ أحد خطوات لتنفيذ اختبار تورنگ على الرغم من 40 عاماً من مناقشته.[41]

أدت مسابقة جائزة لوبنر الأولى في عام 1991 إلى مناقشة متجددة حول جدوى اختبار تورنگ وقيمة متابعته، في كل من الصحافة الشعبية [42] والأوساط الأكاديمية.[43] فاز في المسابقة الأولى برنامج طائش لا يمتلك معلومات استخباراتية محددة تمكنت من خداع المحققين الساذجين في تحديد هوية خاطئة. سلط هذا الضوء على العديد من أوجه القصور في اختبار تورنگ (تمت مناقشته أدناه): ربح الفائز، جزئياً على الأقل، لأنه كان قادراً على "محاكاة أخطاء الكتابة البشرية"؛[42]فقد تم خداع المحققين البسطاء بسهولة;[43] وقد أدى بعض الباحثين في الذكاء الاصطناعي إلى الشعور بأن الاختبار مجرد إلهاء عن البحث الأكثر فائدة.[44]

لم يتم الفوز بالجوائز الفضية (النصية فقط) والذهبية (الصوتية والمرئية). ومع ذلك، فقد منحت المسابقة الميدالية البرونزية كل عام لنظام الحاسب الذي يوضح، في رأي الحكام، سلوك المحادثة "الأكثر إنسانية" بين مشاركات ذلك العام. حاز كيان حاسوبي اللغوي الاصطناعي على الانترنت (A.L.I.C.E.) على الجائزة البرونزية في ثلاث مناسبات في الآونة الأخيرة (2000، 2001، 2004). وقد فاز الذكاء الاصطناعي المتعلم جابرواكي في عامي 2005 و 2006.

تختبر جائزة لوبنر ذكاء المحادثة؛ الفائزون عادةً هم برامج تشاتربوت، أو كيانات محادثة اصطناعية (ACE). قيّدت قواعد جائزة لوبنر الأولية المحادثات: كل إدخال ومحادثة بشرية مخفية حول موضوع واحد،[45]وبالتالي تم تقييد المحققين بسطر واحد من الاستجواب لكل تفاعل كيان. تم رفع قاعدة المحادثة المقيدة لجائزة لوبنر لعام 1995. واختلفت مدة التفاعل بين القاضي والجهة في جوائز لوبنر. في لوبنر 2003، في جامعة سوراي، سُمح لكل محقق بخمس دقائق للتفاعل مع كيان أو آلة أو إنسان مخفي. بين عامي 2004 و 2007، كان زمن التفاعل المسموح به في جوائز لوبنر أكثر من عشرين دقيقة.

إصدارات

يقول شاول تريجر أن هناك ثلاثة إصدارات أساسية على الأقل من اختبار تورنگ، اثنان منها معروضان في "آلات الحوسبة والذكاء" وواحد يصفه بـ "التفسير القياسي"".[46]في حين أن هناك بعض الجدل حول ما إذا كان "التفسير القياسي" هو الذي وصفه تورنگ أو، بدلاً من ذلك، بناءً على قراءة خاطئة لورقته البحثية، فإن هذه النسخ الثلاثة لا تعتبر مكافئة،[46] وتختلف نقاط قوتهم وضعفهم.[47]

يشير هوما شاه إلى أن تورنگ نفسه كان مهتماً بما إذا كان بإمكان الآلة التفكير وكان يوفر طريقة بسيطة لفحص ذلك: من خلال جلسات أسئلة وأجوبة بين الإنسان والآلة.[48] يجادل شاه بأن هناك لعبة محاكاة واحدة وصفها تورنگ يمكن تطبيقها بطريقتين مختلفتين: أ) اختبار المحقق والآلة واحد لواحد، و ب) مقارنة متزامنة بين آلة وإنسان، كلاهما تم استجوابهما بالتوازي من قبل المحقق. [25] نظرًا لأن اختبار تورنگ هو اختبار عدم القدرة على التمييز في قدرة الأداء، فإن النسخة الفعلية تعمم بشكل طبيعي على جميع قدرات الأداء البشري، الفعلية وغير الفعلية (الروبوتية).[49]

لعبة التقليد

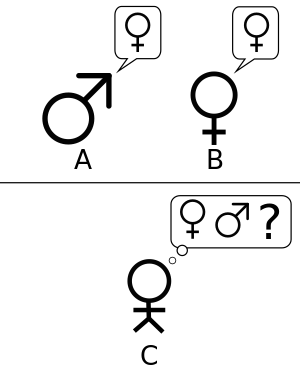

تصف مقالة تورنگ الأصلية لعبة جماعية بسيطة يشارك فيها ثلاثة لاعبين. اللاعب "A" رجل واللاعب "B" امرأة واللاعب "C" (الذي يلعب دور المحقق) من كلا الجنسين. في لعبة التقليد، لا يتمكن اللاعب C من رؤية اللاعب A أو اللاعب B، ولا يمكنه التواصل معهم إلا من خلال الملاحظات المكتوبة. بطرح أسئلة على اللاعب "A" واللاعب "B"، يحاول اللاعب "C" تحديد أيهما هو الرجل وأيهما المرأة. يتمثل دور اللاعب "A" في خداع المحقق لاتخاذ قرار خاطئ، بينما يحاول اللاعب "B" مساعدة المحقق في اتخاذ القرار الصحيح. [7]

ثم يسأل تورنگ:

ماذا سيحدث عندما تأخذ آلة الجزء "A" في هذه اللعبة؟ هل سيقرر المحقق خطأً في كثير من الأحيان عندما تُلعب اللعبة بهذه الطريقة كما يفعل عندما تُلعب اللعبة بين رجل وامرأة؟ هذه الأسئلة تحل محل أسئلتنا الأصلية، "هل تستطيع الآلات التفكير؟"[24]

ظهرت النسخة الثانية لاحقاً في ورقة تورنگ عام 1950. على غرار اختبار لعبة التقليد الأصلية، يتم تنفيذ دور اللاعب "A" بواسطة جهاز حاسب. ومع ذلك، فإن دور اللاعب "B" يؤديه رجل وليس امرأة.

دعنا نركز اهتمامنا على حاسب رقمي معين واحد C هل صحيح أنه من خلال تعديل هذا الحاسب للحصول على مساحة تخزين كافية، وزيادة سرعة عمله بشكل مناسب، وتزويده ببرنامج مناسب، C يمكن جعله يلعب دور A بشكل كافٍ في لعبة التقليد، الجزء B الذي يأخذه رجل؟[24]

في هذا الإصدار، يحاول كل من اللاعب A (الحاسب) واللاعب B خداع المحقق لاتخاذ قرار غير صحيح.

التفسير القياسي

من المفهوم الشائع أن الغرض من اختبار تورنگ ليس تحديد ما إذا كان الحاسب قادراً على خداع المحقق للاعتقاد بأنه إنسان، بل ما إذا كان الحساب يمكنه "تقليد" الإنسان. [7] على الرغم من وجود بعض الخلاف حول ما إذا كان هذا التفسير مقصوداً من قبل تورنگ، يعتقد ستيرت أنه كان كذلك[50]وبالتالي يدمج الإصدار الثاني مع هذا الإصدار، في حين أن البعض الآخر، مثل تريجر، لا يقوم بذلك [46] – أدى هذا مع ذلك إلى ما يمكن اعتباره "التفسير القياسي". في هذا الإصدار، يعتبر اللاعب A جهاز حاسب واللاعب B هو شخص من كلا الجنسين. لا يتمثل دور المحقق في تحديد الذكر والأنثى، ولكن من هو الحاسب ومن هو الإنسان. [51] المشكلة الأساسية في التفسير القياسي هي أن لا يستطيع المحقق التفريق بين المستجيبين البشر والآلة. هناك قضايا تتعلق بالمدة، لكن التفسير القياسي يعتبر بشكل عام هذا القيد كشيء يجب أن يكون معقولاً.

لعبة التقليد مقابل اختبار تورنگ القياسي

نشأ الجدل حول أي من الصيغ البديلة للاختبار يقصد تورنگ. [50] يجادل ستيرت بأنه يمكن استخلاص اختبارين مختلفين من بحثه عام 1950، وأن ملاحظة تورنگ نسبة التقدم غير متساوية. يُشار إلى الاختبار الذي يستخدم لعبة المجموعة ويقارن ترددات النجاح باسم "اختبار لعبة التقليد الأصلي"، بينما يُشار إلى الاختبار الذي يتكون من محكم بشري يتحدث مع إنسان وآلة باسم "اختبار تورنگ القياسي"، مع ملاحظة أن ستيرت يساوي هذا بـ "التفسير القياسي" بدلاً من الإصدار الثاني من لعبة التقليد. يوافق ستيرت على أن اختبار تورنگ القياسي (STT) لديه المشاكل التي يستشهد بها منتقدوه، لكنه يشعر، على النقيض من ذلك، أن اختبار لعبة التقليد الأصلي (اختبار OIG) الذي تم تعريفه على هذا النحو محصن ضد العديد منهم، بسبب اختلاف جوهري: STT، لا تجعل التشابه مع الأداء البشري هو المعيار، على الرغم من أنها تستخدم الأداء البشري في وضع معيار لذكاء الآلة. يمكن للرجل أن يفشل في اختبار OIG، ولكن يُقال إنه من فضائل اختبار الذكاء أن يشير الفشل إلى نقص في الحيلة: يتطلب اختبار OIG الحيلة المرتبطة بالذكاء وليس مجرد "محاكاة سلوك المحادثة البشري". يمكن استخدام الهيكل العام لاختبار OIG مع الإصدارات غير الفعلية من ألعاب التقليد. [52]

لا يزال الكتاب الآخرين[53] فسر تورنگ على أنه يقترح أن لعبة التقليد نفسها هي الاختبار، دون تحديد كيفية مراعاة بيان تورنگ بأن الاختبار الذي اقترحه باستخدام نسخة المجموعة من لعبة التقليد يستند إلى معيار التكرار المقارن للنجاح في ذلك التقليد بدلاً من القدرة على النجاح في جولة واحدة من اللعبة.

اقترح سايجين أن اللعبة الأصلية ربما تكون طريقة لاقتراح تصميم تجريبي أقل تحيزًا لأنه يخفي مشاركة الحاسب.[54] تشتمل لعبة التقليد أيضًا على "اختراق اجتماعي" غير موجود في التفسير القياسي، حيث يتعين على كل من الحاسب والإنسان أن يلعبوا في اللعبة وكأنهم يتظاهرون بأنهم شخص ليسوا كذلك.[55]

هل يجب أن يعلم المحقق بأمر الحاسب؟

جزء مهم من أي اختبار تجريبي هو أنه يجب أن يكون هناك عنصر تحكم. لا يوضح تورنگ أبداً ما إذا كان المحقق في اختباراته يدرك أن أحد المشاركين هو جهاز حاسب. ومع ذلك، إذا كانت هناك آلة لديها القدرة على اجتياز اختبار تورنگ، فسيكون من الآمن افتراض أن التحكم المزدوج الأعمى سيكون ضرورياً.

للعودة إلى لعبة التقليد الأصلية، يذكر فقط أنه سيتم استبدال اللاعب A بآلة، وليس هذا اللاعب C يجب أن يكون على علم بهذا الاستبدال. [24] عندما قام كولبي و إف دي هِلف و إس ڤيبر و آي دي كرايمر باختبار پاري، لقد فعلوا ذلك بافتراض أن المحققين لم يكونوا بحاجة إلى معرفة أن واحداً أو أكثر من الذين تمت مقابلتهم كان جهاز حاسب أثناء الاستجواب. [56] كما أوضح كل من آيز سايجين و پيتر سويرسكي وآخرون ، فإن هذا يحدث فرقاً كبيراً في تنفيذ الاختبار ونتائجه. {[7] دراسة تجريبية تبحث في انتهاكات المذهب الإجتماعي باستخدام نصوص جائزة لوبنر الفردية (المحاور الخفية) لمسابقات الذكاء الاصطناعي بين 1994-1999، وجدت آيز سايجين اختلافات كبيرة بين ردود المشاركون الذين يعرفون ولا يعرفون عن أجهزة الحاسب المشاركة.[57]

نقاط القوة

قابلية التدوير و البساطة

تنبع قوة وجاذبية اختبار تورنگ من بساطته. لم تتمكن فلسفة العقل و علم النفس و علم الأعصاب الحديث من تقديم تعريفات "الذكاء" و "التفكير" التي تكون دقيقة وعامة بما يكفي لتطبيقها على الآلات. بدون مثل هذه التعريفات، لا يمكن الإجابة على الأسئلة المركزية لـ فلسفة الذكاء الاصطناعي. يوفر اختبار تورنگ، حتى لو كان غير كامل، شيئًا يمكن قياسه بالفعل. على هذا النحو، فهي محاولة پراگماتية للإجابة على سؤال فلسفي صعب.

اتساع الموضوع

يسمح شكل الاختبار للمحقق بإعطاء الآلة مجموعة متنوعة من المهام الفكرية. كتب تورنگ أن "طريقة السؤال والجواب تبدو مناسبة لتقديم أي مجال من مجالات المساعي البشرية التي نرغب في تضمينها."[58] يضيف جون هوگلاند أن "فهم الكلمات لا يكفي؛ عليك أن تفهم الموضوع أيضًا."[59]

لاجتياز اختبار تورنگ الذي تم تصميمه جيداً، يجب أن تستخدم الآلة اللغة الطبيعية، الفكر، المعرفة و التعلم. يمكن تمديد الاختبار ليشمل إدخال الفيديو، بالإضافة إلى مدخل يمكن من خلالها تمرير الأشياء: وهذا من شأنه أن يجبر الآلة على إظهار الاستخدام الماهر للتصميم الجيد الرؤية و الروبوتات كذلك. تمثل هذه معاً تقريباً جميع المشكلات الرئيسية التي ترغب أبحاث الذكاء الاصطناعي في حلها.[60]

تم تصميم اختبار فاينباوم للاستفادة من مجموعة واسعة من الموضوعات المتاحة لاختبار تورنگ. إنه شكل محدود من لعبة تورنگ للأسئلة والأجوبة التي تقارن الآلة بقدرات الخبراء في مجالات محددة مثل الأدب أو الكيمياء. لقد حققت آلة واتسن الخاصة بـ IBM نجاحًا في برنامج اختبار المعرفة البشرية بين الرجل مقابل الآلة، "جيوپاردي![61]قالب:Off topic sentence

التأكيد على الذكاء العاطفي والجمالي

نظراً لكونه خريج شرف في جامعة كامبردج في الرياضيات، ربما كان من المتوقع أن يقترح تورنگ اختباراً لذكاء الحاسب يتطلب معرفة متخصصة في بعض المجالات عالية التقنية، وبالتالي توقع نهج أحدث للموضوع. بدلاً من ذلك، كما لوحظ بالفعل، فإن الاختبار الذي وصفه في بحثه الأساسي عام 1950 يتطلب أن يكون الحاسب قادراً على المنافسة بنجاح في لعبة جماعية مشتركة، وهذا من خلال أداء الرجل النموذجي في الإجابة على سلسلة من الأسئلة من أجل التظاهر بشكل مقنع بأنه المرأة المتنافسة.

بالنظر إلى حالة إزدواج الشكل الجنسي البشري على أنها واحدة من أقدم الموضوعات، فإنه يعني ضمنياً في السيناريو أعلاه أن الأسئلة التي يجب الإجابة عليها لن تتضمن المعرفة الواقعية المتخصصة ولا تقنية معالجة المعلومات. سيكون التحدي الذي يواجه الحاسب، بدلاً من ذلك، هو إظهار التعاطف مع دور الأنثى، وإظهار أيضاً حساً جمالياً مميزاً - كلا الصفات معروضة في مقتطف الحوار هذا الذي تخيله تورنگ:

- المحقق: هل يخبرني X من فضلك بطول شعره أو شعرها؟

- المتسابق: شعري مجعد، وأطول خصلات يبلغ طولها حوالي تسع بوصات.

عندما يقدم تورنگ بعض المعرفة المتخصصة في إحدى حواراته المتخيلة، فإن الموضوع ليس الرياضيات أو الإلكترونيات، بل الشعر:

- المحقق: في السطر الأول من السوناتة التي تقول، "هل أقارنك بيوم صيفي"، ألن يكون "يوم ربيعي" أيضاً أم أفضل؟

- شاهد: لن يكون هناك مسح.

- المحقق: وماذا عن "يوم شتاء". هذا من شأنه أن يمسح كل الصواب.

- شاهد: نعم، لكن لا أحد يريد أن يقارَن بيوم الشتاء.

وهكذا يظهر تورنگ مرة أخرى اهتمامه بالتعاطف والحساسية الجمالية كمكونات للذكاء الاصطناعي. وفي ضوء الوعي المتزايد بالتهديد الناجم عن رعونة الذكاء الاصطناعي،[62] الذي قد تم اقتراحه[63]أن هذا التركيز ربما يمثل حدساً مهماً من جانب تورنگ، أي أن الذكاء العاطفي والجمالي سيلعب دوراً رئيسياً في إنشاء "ذكاء اصطناعي ودي". ومع ذلك ، يُلاحظ أيض أن أي إلهام قد يكون تورنگ قادراً على تقديمه في هذا الاتجاه يعتمد على الحفاظ على رؤيته الأصلية، والتي تعني، بالإضافة إلى ذلك، إصدار "تفسير معياري" لاختبار تورنگ - أي، الذي يركز على الذكاء المنطقي فقط - يجب النظر إليه ببعض الحذر.

نقاط الضعف

لم يذكر تورنگ صراحة أن اختبار تورنگ يمكن استخدامه كمقياس للذكاء، أو أي صفة بشرية أخرى. لقد أراد أن يقدم بديلاً واضحًا ومفهومًا لكلمة "يفكر"، والذي يمكنه بعد ذلك استخدامه للرد على الانتقادات لإمكانية "آلات التفكير" واقتراح طرق يمكن أن يمضي بها البحث إلى الأمام.

ومع ذلك، تم اقتراح اختبار تورينج تورنگ "لقدرة الآلة على التفكير" أو "الذكاء". تلقى هذا الاقتراح انتقادات من كل من الفلاسفة وعلماء الحاسب. وهي تفترض أن المحقق يمكنه تحديد ما إذا كانت الآلة "تفكر" من خلال مقارنة سلوكها بالسلوك البشري. تم التشكيك في كل عنصر من عناصر هذا الافتراض: مصداقية حكم المحقق، وقيمة مقارنة السلوك فقط وقيمة مقارنة الآلة بالإنسان. بسبب هذه الاعتبارات وغيرها، شكك بعض باحثي الذكاء الاصطناعي في أهمية الاختبار في مجالهم.

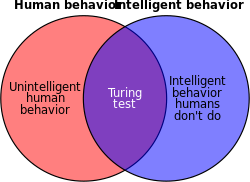

الذكاء البشري مقابل الذكاء بشكل عام

لا يختبر اختبار تورنگ بشكل مباشر ما إذا كان الحاسب يتصرف بذكاء. إنه يختبر فقط ما إذا كان الحاسب يتصرف كإنسان. نظراً لأن السلوك البشري والسلوك الذكي ليسا نفس الشيء تماماً، فقد يفشل الاختبار في قياس الذكاء بدقة بطريقتين:

- بعض السلوك البشري غير ذكي

- يتطلب اختبار تورنگ أن تكون الآلة قادرة على تنفيذ جميع السلوكيات البشرية، بغض النظر عما إذا كانت ذكية أم لا. حتى أنه يختبر السلوكيات التي قد لا تعتبر ذكية على الإطلاق، مثل القابلية للإهانات، [64] إغراء الكذب أو، ببساطة، تكرار مرتفع لـ أخطاء مطبعية. إذا لم تستطع الآلة تقليد هذه السلوكيات غير الذكية بالتفصيل، فإنها تفشل في الاختبار.

- تم رفع هذا الاعتراض من قبل ذي إكونومست، في مقال بعنوان "الغباء الاصطناعي" نُشر بعد فترة وجيزة من مسابقة جائزة لوبنر الأولى في عام 1992. وأشار المقال إلى أن ربح أول فائز من لوبنر كان ويرجع ذلك، جزئياً على الأقل، إلى قدرته على "محاكاة أخطاء الكتابة البشرية". [42] اقترح تورنگ نفسه أن تضيف البرامج أخطاء إلى مخرجاتها، حتى نكوِّن "لاعبين" أفضل للعبة.[65]

- بعض السلوك الذكي غير إنساني

- لا يختبر اختبار تورنگ السلوكيات الذكية للغاية، مثل القدرة على حل المشكلات الصعبة أو التوصل إلى رؤى أصلية. في الواقع، يتطلب الأمر على وجه التحديد الخداع من جانب الآلة: إذا كانت الآلة أكثر ذكاءً من الإنسان، فعليها أن تتجنب عن عمد الظهور بمظهر ذكي للغاية. إذا تم حل مشكلة حسابية من المستحيل عملياً على الإنسان حلها، فسيعلم المحقق أن البرنامج ليس بشرياً، وستفشل الآلة في الاختبار.

- نظرًا لأنه لا يمكن قياس الذكاء الذي يفوق قدرة البشر، لا يمكن استخدام الاختبار لبناء أو تقييم أنظمة أكثر ذكاءً من البشر. لهذا السبب، تم اقتراح العديد من بدائل الاختبار التي من شأنها أن تكون قادرة على تقييم الأنظمة فائقة الذكاء.[66]

الوعي مقابل محاكاة الوعي

يهتم اختبار تورنگ بشكل صارم بكيفية تصرف الموضوع – السلوك الخارجي للآلة. في هذا الصدد، فإنه يأخذ السلوكية أو الوظيفية في دراسة العقل. يشير مثال إليزا إلى أن الآلة التي تجتاز الاختبار قد تكون قادرة على محاكاة سلوك المحادثة البشري باتباع قائمة بسيطة (لكن كبيرة) من القواعد الميكانيكية، دون التفكير أو امتلاك عقل على الإطلاق.

جادل جون سيرل بأنه لا يمكن استخدام السلوك الخارجي لتحديد ما إذا كانت الآلة "في الواقع" تفكر أو مجرد "تحاكي التفكير". [36] حجته الغرفة الصينية مقصودة لإثبات أنه حتى لو كان اختبار تورنگ تعريفاً تشغيلياً جيداً للذكاء، فقد لا يشير إلى أن الآلة لديها عقل، وعي، أو نية. (النية مصطلح فلسفي يشير إلى قوة الأفكار لتكون "حول" شيء ما.)

توقع تورنگ هذا الخط من النقد في ورقته الأصلية،[67] كاتباً:

لا أرغب في إعطاء الانطباع بأنني أعتقد أنه لا يوجد لغز حول الوعي. هناك، على سبيل المثال، شيء من التناقض مرتبط بأي محاولة لتحديدها. لكنني لا أعتقد أن هذه الألغاز تحتاج بالضرورة إلى حل قبل أن نتمكن من الإجابة على السؤال الذي يهمنا في هذه الورقة.[68]

بساطة المحققين والمغالطة المجسمة

عملياً، يمكن بسهولة السيطرة على نتائج الاختبار ليس من خلال ذكاء الحاسب، ولكن من خلال المواقف أو المهارة أو بساطة السائل.

لا يحدد تورنگ المهارات والمعرفة الدقيقة التي يطلبها المحقق في وصفه للاختبار، لكنه استخدم مصطلح "المحقق المتوسط": "[ال]محقق العادي لن يكون لديه أكثر من 70 في المائة من فرصة اتخاذ الحق تحديد الهوية بعد خمس دقائق من الاستجواب ".[69]

لقد خدعت برامج تشاتربوت مثل إليزا مراراً وتكراراً الأشخاص المطمئنين للاعتقاد بأنهم يتواصلون مع البشر. في هذه الحالات، لا يدرك "المحققون" حتى إمكانية تفاعلهم مع أجهزة الحاسب. لكي تظهر الإنسان بشكل ناجح، ليست هناك حاجة لامتلاك الآلة لأي ذكاء على الإطلاق، ولا يتطلب الأمر سوى تشابه سطحي مع السلوك البشري.

استخدمت منافسات جائزة لوبنر الأولية محققين "غير متمرسين" خدعتهم الآلات بسهولة.[43] منذ عام 2004، قام منظمو جائزة لوبنر بنشر فلاسفة وعلماء حاسب وصحفيين بين المحققين. ومع ذلك، فقد خدعت الآلات بعض هؤلاء الخبراء.[70]

يشير مايكل شيرمر إلى أن البشر يختارون باستمرار اعتبار الأشياء غير البشرية كإنسان كلما سمحت لهم الفرصة، وهو خطأ يسمى مغالطة مجسمة: يتحدثون إلى سياراتهم وينسبون الرغبة والنوايا إلى القوى الطبيعية (على سبيل المثال، "الطبيعة تكره الفراغ")، وتعبد الشمس ككائن شبيه بالإنسان بذكاء. يجادل شيرمر أنه إذا تم تطبيق اختبار تورنگ على الأشياء الدينية، فإن التماثيل والصخور والأماكن غير الحية اجتازت الاختبار باستمرار عبر التاريخ.[citation needed]هذا الميل البشري نحو التجسيم يقلل بشكل فعال من مستوى اختبار تورنگ، ما لم يتم تدريب المحققين بشكل خاص على تجنبه.

خطأ في تعريف الإنسان

إحدى السمات المثيرة للاهتمام لاختبار تورنگ هي تواتر التأثير المتحالف، عندما يخطئ المحققون في تعريف البشر المتحالفين (المختبرين) على أنهم آلات. لقد تم اقتراح أن ما يتوقعه المحققون من ردود فعل بشرية ليس بالضرورة نموذجياً للبشر. نتيجة لذلك، يمكن تصنيف بعض الأفراد على أنهم آلات. لذلك يمكن أن يعمل هذا لصالح آلة منافسة. يُطلب من البشر "التصرف بأنفسهم"، ولكن أحياناً تكون إجاباتهم أشبه بما يتوقع المحقق أن تقوله الآلة.[71] وهذا يثير التساؤل حول كيفية ضمان تحفيز البشر على "التصرف بشكل إنساني".

الخمود

يتمثل أحد الجوانب المهمة لاختبار تورنگ في أن الآلة يجب أن تتخلى عن نفسها باعتبارها آلة من خلال نطقها. يجب على المحقق بعد ذلك إجراء "التعريف الصحيح" عن طريق تحديد الآلة بشكل صحيح على أنها ليست كذلك. ومع ذلك، إذا بقيت الآلة صامتة أثناء المحادثة، فلا يمكن للمحقق تحديد الآلة بدقة إلا عن طريق التخمين المحسوب.[72]حتى مع الأخذ في الاعتبار وجود إنسان موازٍ / مخفي كجزء من الاختبار قد لا يساعد الموقف لأن البشر غالباً ما يتم تعريفهم بشكل خاطئ على أنهم آلة.[73]

Impracticality and irrelevance: the Turing test and AI research

Mainstream AI researchers argue that trying to pass the Turing test is merely a distraction from more fruitful research.[74] Indeed, the Turing test is not an active focus of much academic or commercial effort—as Stuart Russell and Peter Norvig write: "AI researchers have devoted little attention to passing the Turing test."[75] There are several reasons.

First, there are easier ways to test their programs. Most current research in AI-related fields is aimed at modest and specific goals, such as automated scheduling, object recognition, or logistics. To test the intelligence of the programs that solve these problems, AI researchers simply give them the task directly. Russell and Norvig suggest an analogy with the history of flight: Planes are tested by how well they fly, not by comparing them to birds. "Aeronautical engineering texts," they write, "do not define the goal of their field as 'making machines that fly so exactly like pigeons that they can fool other pigeons.'"[75]

Second, creating lifelike simulations of human beings is a difficult problem on its own that does not need to be solved to achieve the basic goals of AI research. Believable human characters may be interesting in a work of art, a game, or a sophisticated user interface, but they are not part of the science of creating intelligent machines, that is, machines that solve problems using intelligence.

Turing wanted to provide a clear and understandable example to aid in the discussion of the philosophy of artificial intelligence.[76] John McCarthy observes that the philosophy of AI is "unlikely to have any more effect on the practice of AI research than philosophy of science generally has on the practice of science."[77]

Cognitive science

Robert French (1990) makes the case that an interrogator can distinguish human and non-human interlocutors by posing questions that reveal the low-level (i.e., unconscious) processes of human cognition, as studied by cognitive science. Such questions reveal the precise details of the human embodiment of thought and can unmask a computer unless it experiences the world as humans do.[78]

Variations

Numerous other versions of the Turing test, including those expounded above, have been raised through the years.

Reverse Turing test and CAPTCHA

A modification of the Turing test wherein the objective of one or more of the roles have been reversed between machines and humans is termed a reverse Turing test. An example is implied in the work of psychoanalyst Wilfred Bion,[79] who was particularly fascinated by the "storm" that resulted from the encounter of one mind by another. In his 2000 book,[80] among several other original points with regard to the Turing test, literary scholar Peter Swirski discussed in detail the idea of what he termed the Swirski test—essentially the reverse Turing test. He pointed out that it overcomes most if not all standard objections levelled at the standard version.

Carrying this idea forward, R. D. Hinshelwood[81] described the mind as a "mind recognizing apparatus". The challenge would be for the computer to be able to determine if it were interacting with a human or another computer. This is an extension of the original question that Turing attempted to answer but would, perhaps, offer a high enough standard to define a machine that could "think" in a way that we typically define as characteristically human.

CAPTCHA is a form of reverse Turing test. Before being allowed to perform some action on a website, the user is presented with alphanumerical characters in a distorted graphic image and asked to type them out. This is intended to prevent automated systems from being used to abuse the site. The rationale is that software sufficiently sophisticated to read and reproduce the distorted image accurately does not exist (or is not available to the average user), so any system able to do so is likely to be a human.

Software that could reverse CAPTCHA with some accuracy by analysing patterns in the generating engine started being developed soon after the creation of CAPTCHA.[82] In 2013, researchers at Vicarious announced that they had developed a system to solve CAPTCHA challenges from Google, Yahoo!, and PayPal up to 90% of the time.[83] In 2014, Google engineers demonstrated a system that could defeat CAPTCHA challenges with 99.8% accuracy.[84] In 2015, Shuman Ghosemajumder, former click fraud czar of Google, stated that there were cybercriminal sites that would defeat CAPTCHA challenges for a fee, to enable various forms of fraud.[85]

Subject matter expert Turing test

Another variation is described as the subject-matter expert Turing test, where a machine's response cannot be distinguished from an expert in a given field. This is also known as a "Feigenbaum test" and was proposed by Edward Feigenbaum in a 2003 paper.[86]

Total Turing test

The "Total Turing test"[49] variation of the Turing test, proposed by cognitive scientist Stevan Harnad,[87] adds two further requirements to the traditional Turing test. The interrogator can also test the perceptual abilities of the subject (requiring computer vision) and the subject's ability to manipulate objects (requiring robotics).[88]

Electronic health records

A letter published in Communications of the ACM[89] describes the concept of generating a synthetic patient population and proposes a variation of Turing test to assess the difference between synthetic and real patients. The letter states: "In the EHR context, though a human physician can readily distinguish between synthetically generated and real live human patients, could a machine be given the intelligence to make such a determination on its own?" and further the letter states: "Before synthetic patient identities become a public health problem, the legitimate EHR market might benefit from applying Turing Test-like techniques to ensure greater data reliability and diagnostic value. Any new techniques must thus consider patients' heterogeneity and are likely to have greater complexity than the Allen eighth-grade-science-test is able to grade."

Minimum intelligent signal test

The minimum intelligent signal test was proposed by Chris McKinstry as "the maximum abstraction of the Turing test",[90] in which only binary responses (true/false or yes/no) are permitted, to focus only on the capacity for thought. It eliminates text chat problems like anthropomorphism bias, and does not require emulation of unintelligent human behaviour, allowing for systems that exceed human intelligence. The questions must each stand on their own, however, making it more like an IQ test than an interrogation. It is typically used to gather statistical data against which the performance of artificial intelligence programs may be measured.[91]

Hutter Prize

The organisers of the Hutter Prize believe that compressing natural language text is a hard AI problem, equivalent to passing the Turing test.

The data compression test has some advantages over most versions and variations of a Turing test, including:

- It gives a single number that can be directly used to compare which of two machines is "more intelligent."

- It does not require the computer to lie to the judge

The main disadvantages of using data compression as a test are:

- It is not possible to test humans this way.

- It is unknown what particular "score" on this test—if any—is equivalent to passing a human-level Turing test.

Other tests based on compression or Kolmogorov complexity

A related approach to Hutter's prize which appeared much earlier in the late 1990s is the inclusion of compression problems in an extended Turing test.[92] or by tests which are completely derived from Kolmogorov complexity.[93] Other related tests in this line are presented by Hernandez-Orallo and Dowe.[94]

Algorithmic IQ, or AIQ for short, is an attempt to convert the theoretical Universal Intelligence Measure from Legg and Hutter (based on Solomonoff's inductive inference) into a working practical test of machine intelligence.[95]

Two major advantages of some of these tests are their applicability to nonhuman intelligences and their absence of a requirement for human testers.

Ebert test

The Turing test inspired the Ebert test proposed in 2011 by film critic Roger Ebert which is a test whether a computer-based synthesised voice has sufficient skill in terms of intonations, inflections, timing and so forth, to make people laugh.[96]

Predictions

Turing predicted that machines would eventually be able to pass the test; in fact, he estimated that by the year 2000, machines with around 100 MB of storage would be able to fool 30% of human judges in a five-minute test, and that people would no longer consider the phrase "thinking machine" contradictory.[5] (In practice, from 2009–2012, the Loebner Prize chatterbot contestants only managed to fool a judge once,[97] and that was only due to the human contestant pretending to be a chatbot.[98]) He further predicted that machine learning would be an important part of building powerful machines, a claim considered plausible by contemporary researchers in artificial intelligence.[69]

In a 2008 paper submitted to 19th Midwest Artificial Intelligence and Cognitive Science Conference, Dr. Shane T. Mueller predicted a modified Turing test called a "Cognitive Decathlon" could be accomplished within five years.[99]

By extrapolating an exponential growth of technology over several decades, futurist Ray Kurzweil predicted that Turing test-capable computers would be manufactured in the near future. In 1990, he set the year around 2020.[100] By 2005, he had revised his estimate to 2029.[101]

The Long Bet Project Bet Nr. 1 is a wager of $20,000 between Mitch Kapor (pessimist) and Ray Kurzweil (optimist) about whether a computer will pass a lengthy Turing test by the year 2029. During the Long Now Turing Test, each of three Turing test judges will conduct online interviews of each of the four Turing test candidates (i.e., the computer and the three Turing test human foils) for two hours each for a total of eight hours of interviews. The bet specifies the conditions in some detail.[102]

Conferences

Turing Colloquium

1990 marked the fortieth anniversary of the first publication of Turing's "Computing Machinery and Intelligence" paper, and, saw renewed interest in the test. Two significant events occurred in that year: The first was the Turing Colloquium, which was held at the University of Sussex in April, and brought together academics and researchers from a wide variety of disciplines to discuss the Turing test in terms of its past, present, and future; the second was the formation of the annual Loebner Prize competition.

Blay Whitby lists four major turning points in the history of the Turing test – the publication of "Computing Machinery and Intelligence" in 1950, the announcement of Joseph Weizenbaum's ELIZA in 1966, Kenneth Colby's creation of PARRY, which was first described in 1972, and the Turing Colloquium in 1990.[103]

2005 Colloquium on Conversational Systems

In November 2005, the University of Surrey hosted an inaugural one-day meeting of artificial conversational entity developers,[104] attended by winners of practical Turing tests in the Loebner Prize: Robby Garner, Richard Wallace and Rollo Carpenter. Invited speakers included David Hamill, Hugh Loebner (sponsor of the Loebner Prize) and Huma Shah.

2008 AISB Symposium

In parallel to the 2008 Loebner Prize held at the University of Reading,[105] the Society for the Study of Artificial Intelligence and the Simulation of Behaviour (AISB), hosted a one-day symposium to discuss the Turing test, organised by John Barnden, Mark Bishop, Huma Shah and Kevin Warwick.[106] The speakers included the Royal Institution's Director Baroness Susan Greenfield, Selmer Bringsjord, Turing's biographer Andrew Hodges, and consciousness scientist Owen Holland. No agreement emerged for a canonical Turing test, though Bringsjord expressed that a sizeable prize would result in the Turing test being passed sooner.

The Alan Turing Year, and Turing100 in 2012

Throughout 2012, a number of major events took place to celebrate Turing's life and scientific impact. The Turing100 group supported these events and also, organised a special Turing test event in Bletchley Park on 23 June 2012 to celebrate the 100th anniversary of Turing's birth.

See also

- Natural language processing

- Artificial intelligence in fiction

- Blindsight

- Causality

- Computer game bot Turing Test

- Detroit: Become Human (Game developed by Quantic Dream)

- Explanation

- Explanatory gap

- Functionalism

- Graphics Turing Test

- HAL 9000 (computer from 2001: A Space Odyssey)

- Ex Machina (film)

- Hard problem of consciousness

- Ideological Turing Test

- List of things named after Alan Turing

- Mark V. Shaney (Usenet bot)

- Mind-body problem

- Mirror neuron

- Philosophical zombie

- Problem of other minds

- Reverse engineering

- Sentience

- Simulated reality

- Technological singularity

- Theory of mind

- Uncanny valley

- Voight-Kampff machine (fictitious Turing test from Blade Runner)

- Westworld (TV series)

- Winograd Schema Challenge

- SHRDLU

Notes

- ^ Image adapted from Saygin 2000

- ^ أ ب (Turing 1950, p. 442) Turing does not call his idea "Turing test", but rather the "imitation game"; however, later literature has reserved the term "imitation game" to describe a particular version of the test. See #Versions of the Turing test, below. Turing gives a more precise version of the question later in the paper: "[T]hese questions [are] equivalent to this, 'Let us fix our attention on one particular digital computer C. Is it true that by modifying this computer to have an adequate storage, suitably increasing its speed of action, and providing it with an appropriate programme, C can be made to play satisfactorily the part of A in the imitation game, the part of B being taken by a man?'" (Turing 1950, p. 442)

- ^ Turing originally suggested a teleprinter, one of the few text-only communication systems available in 1950. (Turing 1950, p. 433)

- ^ "The Turing Test, 1950". turing.org.uk. The Alan Turing Internet Scrapbook.

- ^ أ ب ت ث Turing 1950, p. 433.

- ^ أ ب Turing 1950, pp. 442–454 and see Russell & Norvig (2003, p. 948), where they comment, "Turing examined a wide variety of possible objections to the possibility of intelligent machines, including virtually all of those that have been raised in the half century since his paper appeared."

- ^ أ ب ت ث ج ح Saygin 2000.

- ^ Russell & Norvig 2003, pp. 2–3, 948.

- ^ Swiechowski, Maciej (2020), "Game AI Competitions: Motivation for the Imitation Game-Playing Competition", Proceedings of the 15th Conference on Computer Science and Information Systems (FedCSIS 2020) (IEEE Publishing): 155–160, https://annals-csis.org/proceedings/2020/pliks/126.pdf, retrieved on 8 September 2020.

- ^ Descartes, René (1996). Discourse on Method and Meditations on First Philosophy. New Haven & London: Yale University Press. pp. 34–35. ISBN 978-0300067729.

- ^ Diderot, D. (2007), Pensees Philosophiques, Addition aux Pensees Philosophiques, [Flammarion], p. 68, ISBN 978-2-0807-1249-3

- ^ For an example of property dualism, see Qualia.

- ^ Noting that materialism does not necessitate the possibility of artificial minds (for example, Roger Penrose), any more than dualism necessarily precludes the possibility. (See, for example, Property dualism.)

- ^ Ayer, A. J. (2001), "Language, Truth and Logic", Nature (Penguin) 138 (3498): 140, doi:, ISBN 978-0-334-04122-1, Bibcode: 1936Natur.138..823G

- ^ The Dartmouth conferences of 1956 are widely considered the "birth of AI". (Crevier 1993, p. 49)

- ^ McCorduck 2004, p. 95.

- ^ Copeland 2003, p. 1.

- ^ Copeland 2003, p. 2.

- ^ "Intelligent Machinery" (1948) was not published by Turing, and did not see publication until 1968 in:

- Evans, A. D. J.; Robertson (1968), Cybernetics: Key Papers, University Park Press

- ^ Turing 1948, p. 412.

- ^ In 1948, working with his former undergraduate colleague, DG Champernowne, Turing began writing a chess program for a computer that did not yet exist and, in 1952, lacking a computer powerful enough to execute the program, played a game in which he simulated it, taking about half an hour over each move. The game was recorded, and the program lost to Turing's colleague Alick Glennie, although it is said that it won a game against Champernowne's wife.

- ^ Turing 1948, p. [صفحة مطلوبة].

- ^ Harnad 2004, p. 1.

- ^ أ ب ت ث ج Turing 1950, p. 434.

- ^ أ ب Shah 2010.

- ^ Turing 1950, p. 446.

- ^ Turing 1952, pp. 524–525. Turing does not seem to distinguish between "man" as a gender and "man" as a human. In the former case, this formulation would be closer to the imitation game, whereas in the latter it would be closer to current depictions of the test.

- ^ Weizenbaum 1966, p. 37.

- ^ أ ب ت Weizenbaum 1966, p. 42.

- ^ Thomas 1995, p. 112.

- ^ Bowden 2006, p. 370.

- ^ Colby et al. 1972, p. 42.

- ^ Saygin 2000, p. 501.

- ^ Withers, Steven (11 December 2007), Flirty Bot Passes for Human, http://www.itwire.com/your-it-news/home-it/15748-flirty-bot-passes-for-human

- ^ Williams, Ian (10 December 2007), Online Love Seerkers Warned Flirt Bots, http://www.v3.co.uk/vnunet/news/2205441/online-love-seekers-warned-flirt-bots

- ^ أ ب Searle 1980.

- ^ There are a large number of arguments against Searle's Chinese room. A few are:

- Hauser, Larry (1997), "Searle's Chinese Box: Debunking the Chinese Room Argument", Minds and Machines 7 (2): 199–226, doi:.

- Rehman, Warren. (19 Jul 2009), Argument against the Chinese Room Argument, Archived from the original on 19 July 2010, https://web.archive.org/web/20100719002718/http://knol.google.com/k/warren-rehman/argument-against-the-chinese-room/19dflpeo1gadq/2.

- Thornley, David H. (1997), Why the Chinese Room Doesn't Work, Archived from the original on 26 April 2009, https://web.archive.org/web/20090426055512/http://www.visi.com/~thornley/david/philosophy/searle.html

- ^ M. Bishop & J. Preston (eds.) (2001) Essays on Searle's Chinese Room Argument. Oxford University Press.

- ^ Saygin 2000, p. 479.

- ^ Sundman 2003.

- ^ Loebner 1994.

- ^ أ ب ت "Artificial Stupidity" 1992.

- ^ أ ب ت Shapiro 1992 and Shieber 1994, amongst others.

- ^ Shieber 1994.

- ^ قالب:Scientific American Frontiers

- ^ أ ب ت Traiger 2000.

- ^ Saygin 2008.

- ^ Shah 2011.

- ^ أ ب Oppy, Graham & Dowe, David (2011) The Turing Test. Stanford Encyclopedia of Philosophy.

- ^ أ ب Moor 2003.

- ^ Traiger 2000, p. 99.

- ^ Sterrett 2000.

- ^ Genova 1994, Hayes & Ford 1995, Heil 1998, Dreyfus 1979

- ^ R.Epstein, G. Roberts, G. Poland, (eds.) Parsing the Turing Test: Philosophical and Methodological Issues in the Quest for the Thinking Computer. Springer: Dordrecht, Netherlands

- ^ Thompson, Clive (يوليو 2005). "The Other Turing Test". Issue 13.07. WIRED magazine. Retrieved 10 سبتمبر 2011.

As a gay man who spent nearly his whole life in the closet, Turing must have been keenly aware of the social difficulty of constantly faking your real identity. And there's a delicious irony in the fact that decades of AI scientists have chosen to ignore Turing's gender-twisting test – only to have it seized upon by three college-age women

. (Full version). - ^ Colby et al. 1972.

- ^ Saygin & Cicekli 2002.

- ^ Turing 1950, under "Critique of the New Problem".

- ^ Haugeland 1985, p. 8.

- ^ "These six disciplines," write Stuart J. Russell and Peter Norvig, "represent most of AI." Russell & Norvig 2003, p. 3

- ^ Watson:

- Watson Wins 'Jeopardy!' The IBM Challenge, 16 February 2011, Archived from the original on 22 May 2011, https://web.archive.org/web/20110522000925/http://www.jeopardy.com/news/IBMchallenge.php

- Shah, Huma (5 April 2011), Turing's misunderstood imitation game and IBM's Watson success, https://www.academia.edu/474617

- ^ Urban, Tim (فبراير 2015). "The AI Revolution: Our Immortality or Extinction". Wait But Why. Retrieved 5 أبريل 2015.

- ^ Smith, G. W. (27 مارس 2015). "Art and Artificial Intelligence". ArtEnt. Archived from the original on 25 يونيو 2017. Retrieved 27 مارس 2015.

{{cite web}}: CS1 maint: bot: original URL status unknown (link) - ^ Saygin & Cicekli 2002, pp. 227–258.

- ^ Turing 1950, p. 448.

- ^ Several alternatives to the Turing test, designed to evaluate machines more intelligent than humans:

- Jose Hernandez-Orallo (2000), "Beyond the Turing Test", Journal of Logic, Language and Information 9 (4): 447–466, doi:.

- D L Dowe & A R Hajek (1997), "A computational extension to the Turing Test", Proceedings of the 4th Conference of the Australasian Cognitive Science Society, Archived from the original on 28 June 2011, https://web.archive.org/web/20110628194905/http://www.csse.monash.edu.au/publications/1997/tr-cs97-322-abs.html, retrieved on 21 July 2009.

- Shane Legg & Marcus Hutter (2007), "Universal Intelligence: A Definition of Machine Intelligence", Minds and Machines 17 (4): 391–444, doi:, Bibcode: 2007arXiv0712.3329L, Archived from the original on 18 June 2009, https://web.archive.org/web/20090618152351/http://www.vetta.org/documents/UniversalIntelligence.pdf, retrieved on 21 July 2009.

- Hernandez-Orallo, J; Dowe, D L (2010), "Measuring Universal Intelligence: Towards an Anytime Intelligence Test", Artificial Intelligence 174 (18): 1508–1539, doi:.

- ^ Russell & Norvig (2003, pp. 958–960) identify Searle's argument with the one Turing answers.

- ^ Turing 1950.

- ^ أ ب Turing 1950, p. 442.

- ^ Shah & Warwick 2010.

- ^ Kevin Warwick; Huma Shah (يونيو 2014). "Human Misidentification in Turing Tests". Journal of Experimental and Theoretical Artificial Intelligence. 27 (2): 123–135. doi:10.1080/0952813X.2014.921734. S2CID 45773196.

- ^ Warwick, Kevin; Shah, Huma (4 مارس 2017). "Taking the fifth amendment in Turing's imitation game" (PDF). Journal of Experimental & Theoretical Artificial Intelligence (in الإنجليزية). 29 (2): 287–297. doi:10.1080/0952813X.2015.1132273. ISSN 0952-813X. S2CID 205634569.

- ^ Warwick, Kevin; Shah, Huma (4 مارس 2015). "Human misidentification in Turing tests". Journal of Experimental & Theoretical Artificial Intelligence (in الإنجليزية). 27 (2): 123–135. doi:10.1080/0952813X.2014.921734. ISSN 0952-813X. S2CID 45773196.

- ^ Shieber 1994, p. 77.

- ^ أ ب Russell & Norvig 2003, p. 3.

- ^ Turing 1950, under the heading "The Imitation Game," where he writes, "Instead of attempting such a definition I shall replace the question by another, which is closely related to it and is expressed in relatively unambiguous words."

- ^ McCarthy, John (1996), The Philosophy of Artificial Intelligence, http://www-formal.stanford.edu/jmc/aiphil/node2.html#SECTION00020000000000000000

- ^ French, Robert M., "Subcognition and the Limits of the Turing Test", Mind 99 (393): 53–65

- ^ Bion 1979.

- ^ Swirski 2000.

- ^ Hinshelwood 2001.

- ^ Malik, Jitendra; Mori, Greg, Breaking a Visual CAPTCHA, http://www.cs.sfu.ca/~mori/research/gimpy/

- ^ Pachal, Pete, Captcha FAIL: Researchers Crack the Web's Most Popular Turing Test, http://mashable.com/2013/10/28/captcha-defeated/#QyX1ZwnE9sqr

- ^ Tung, Liam, Google algorithm busts CAPTCHA with 99.8 percent accuracy, http://www.zdnet.com/article/google-algorithm-busts-captcha-with-99-8-percent-accuracy/

- ^ Ghosemajumder, Shuman, The Imitation Game: The New Frontline of Security, http://www.infoq.com/presentations/ai-security

- ^ McCorduck 2004, pp. 503–505, Feigenbaum 2003. The subject matter expert test is also mentioned in Kurzweil (2005)

- ^ Gent, Edd (2014), The Turing Test: brain-inspired computing's multiple-path approach, https://eandt.theiet.org/content/articles/2014/11/the-turing-test-brain-inspired-computings-multiple-path-approach/

- ^ Russell & Norvig 2010, p. 3.

- ^ Cacm Staff (2017). "A leap from artificial to intelligence". Communications of the ACM. 61: 10–11. doi:10.1145/3168260.

- ^ http://tech.groups.yahoo.com/group/arcondev/message/337

- ^ McKinstry, Chris (1997), "Minimum Intelligent Signal Test: An Alternative Turing Test", Canadian Artificial Intelligence (41), http://hps.elte.hu/~gk/Loebner/kcm9512.htm

- ^ D L Dowe & A R Hajek (1997), "A computational extension to the Turing Test", Proceedings of the 4th Conference of the Australasian Cognitive Science Society, Archived from the original on 28 June 2011, https://web.archive.org/web/20110628194905/http://www.csse.monash.edu.au/publications/1997/tr-cs97-322-abs.html, retrieved on 21 July 2009.

- ^ Jose Hernandez-Orallo (2000), "Beyond the Turing Test", Journal of Logic, Language and Information 9 (4): 447–466, doi:.

- ^ Hernandez-Orallo & Dowe 2010.

- ^ An Approximation of the Universal Intelligence Measure, Shane Legg and Joel Veness, 2011 Solomonoff Memorial Conference

- ^ Alex_Pasternack (18 أبريل 2011). "A MacBook May Have Given Roger Ebert His Voice, But An iPod Saved His Life (Video)". Motherboard. Archived from the original on 6 سبتمبر 2011. Retrieved 12 سبتمبر 2011.

He calls it the "Ebert Test," after Turing's AI standard...

- ^ "Loebner | the Latest Social Media News & Updates".

- ^ "Prizewinning chatbot steers the conversation".

- ^ Shane T. Mueller (2008), "Is the Turing Test Still Relevant? A Plan for Developing the Cognitive Decathlon to Test Intelligent Embodied Behavior", Paper Submitted to the 19th Midwest Artificial Intelligence and Cognitive Science Conference: 8pp, Archived from the original on 5 November 2010, https://web.archive.org/web/20101105071127/http://www.dod.mil/pubs/foi/darpa/08_F_0799Is_the_Turing_test_Still_Relevant.pdf, retrieved on 8 September 2010

- ^ Kurzweil 1990.

- ^ Kurzweil 2005.

- ^ Kapor, Mitchell; Kurzweil, Ray, By 2029 no computer – or "machine intelligence" – will have passed the Turing Test, http://www.longbets.org/1#terms

- ^ Whitby 1996, p. 53.

- ^ ALICE Anniversary and Colloquium on Conversation, A.L.I.C.E. Artificial Intelligence Foundation, http://www.alicebot.org/bbbbbbb.html, retrieved on 29 March 2009

- ^ Loebner Prize 2008, University of Reading, http://www.reading.ac.uk/cirg/loebner/cirg-loebner-main.asp, retrieved on 29 March 2009[dead link]

- ^ AISB 2008 Symposium on the Turing Test, Society for the Study of Artificial Intelligence and the Simulation of Behaviour, Archived from the original on 18 March 2009, https://web.archive.org/web/20090318025939/http://aisb.org.uk/events/turingevent.shtml, retrieved on 29 March 2009

References

- "Artificial Stupidity", The Economist 324 (7770): 14, 1 August 1992

- Bion, W.S. (1979), "Making the best of a bad job", Clinical Seminars and Four Papers, Abingdon: Fleetwood Press.

- Bowden, Margaret A. (2006), Mind As Machine: A History of Cognitive Science, Oxford University Press, ISBN 978-0-19-924144-6, https://archive.org/details/mindasmachinehis0001bode

- Colby, K. M.; Hilf, F. D.; Weber, S.; Kraemer, H. (1972), "Turing-like indistinguishability tests for the validation of a computer simulation of paranoid processes", Artificial Intelligence 3: 199–221, doi:

- Copeland, Jack (2003), Moor, James, ed., The Turing Test, Springer, ISBN 978-1-4020-1205-1

- Crevier, Daniel (1993), AI: The Tumultuous Search for Artificial Intelligence, New York, NY: BasicBooks, ISBN 978-0-465-02997-6

- Dreyfus, Hubert (1979), What Computers Still Can't Do, New York: MIT Press, ISBN 978-0-06-090613-9, https://archive.org/details/whatcomputerscan00hube

- Feigenbaum, Edward A. (2003), "Some challenges and grand challenges for computational intelligence", Journal of the ACM 50 (1): 32–40, doi:

- French, Robert M. (1990), "Subcognition and the Limits of the Turing Test", Mind 99 (393): 53–65, doi:, https://semanticscholar.org/paper/db2e35bb875bce89474e60e814881dff30fb3228

- Genova, J. (1994), "Turing's Sexual Guessing Game", Social Epistemology 8 (4): 314–326, doi:

- Harnad, Stevan (2004), "The Annotation Game: On Turing (1950) on Computing, Machinery, and Intelligence", in Epstein, Robert; Peters, Grace, The Turing Test Sourcebook: Philosophical and Methodological Issues in the Quest for the Thinking Computer, Klewer, http://cogprints.org/3322/

- Haugeland, John (1985), Artificial Intelligence: The Very Idea, Cambridge, Massachusetts: MIT Press.

- Hayes, Patrick; Ford, Kenneth (1995), "Turing Test Considered Harmful", Proceedings of the Fourteenth International Joint Conference on Artificial Intelligence (IJCAI95-1), Montreal, Quebec, Canada.: 972–997

- Heil, John (1998), Philosophy of Mind: A Contemporary Introduction, London and New York: Routledge, ISBN 978-0-415-13060-8

- Hinshelwood, R.D. (2001), Group Mentality and Having a Mind: Reflections on Bion's work on groups and on psychosis

- Kurzweil, Ray (1990), The Age of Intelligent Machines, Cambridge, Massachusetts: MIT Press, ISBN 978-0-262-61079-7

- Kurzweil, Ray (2005), The Singularity is Near, Penguin Books, ISBN 978-0-670-03384-3, https://archive.org/details/singularityisnea00kurz

- Loebner, Hugh Gene (1994), "In response", Communications of the ACM 37 (6): 79–82, doi:, http://loebner.net/Prizef/In-response.html, retrieved on 22 March 2008

- قالب:McCorduck 2004

- Moor, James, ed. (2003), The Turing Test: The Elusive Standard of Artificial Intelligence, Dordrecht: Kluwer Academic Publishers, ISBN 978-1-4020-1205-1

- Penrose, Roger (1989), The Emperor's New Mind: Concerning Computers, Minds, and The Laws of Physics, Oxford University Press, ISBN 978-0-14-014534-2

- قالب:Cite AIMA

- Russell, Stuart J.; Norvig, Peter (2010), Artificial Intelligence: A Modern Approach (3rd ed.), Upper Saddle River, NJ: Prentice Hall, ISBN 978-0-13-604259-4

- Saygin, A. P.; Cicekli, I.; Akman, V. (2000), "Turing Test: 50 Years Later", Minds and Machines 10 (4): 463–518, doi:, http://crl.ucsd.edu/~saygin/papers/MMTT.pdf. Reprinted in Moor (2003, pp. 23–78).

- Saygin, A. P.; Cicekli, I. (2002), "Pragmatics in human-computer conversation", Journal of Pragmatics 34 (3): 227–258, doi:.

- Saygin, A.P.; Roberts, Gary; Beber, Grace (2008), "Comments on "Computing Machinery and Intelligence" by Alan Turing", in Epstein, R.; Roberts, G.; Poland, G., Parsing the Turing Test: Philosophical and Methodological Issues in the Quest for the Thinking Computer, Dordrecht, Netherlands: Springer, doi:, ISBN 978-1-4020-9624-2, Bibcode: 2009pttt.book.....E

- Searle, John (1980), "Minds, Brains and Programs", Behavioral and Brain Sciences 3 (3): 417–457, doi:, http://members.aol.com/NeoNoetics/MindsBrainsPrograms.html. Page numbers above refer to a standard pdf print of the article. See also Searle's original draft.

- Shah, Huma; Warwick, Kevin (2009a), "Emotion in the Turing Test: A Downward Trend for Machines in Recent Loebner Prizes", in Vallverdú, Jordi; Casacuberta, David, Handbook of Research on Synthetic Emotions and Sociable Robotics: New Applications in Affective Computing and Artificial Intelligence, Information Science, IGI, ISBN 978-1-60566-354-8

- Shah, Huma; Warwick, Kevin (June 2010), "Hidden Interlocutor Misidentification in Practical Turing Tests", Minds and Machines 20 (3): 441–454, doi:

- Shah, Huma; Warwick, Kevin (April 2010), "Testing Turing's five minutes, parallel‐paired imitation game", Kybernetes 4 (3): 449–465, doi:

- Shapiro, Stuart C. (1992), "The Turing Test and the economist", ACM SIGART Bulletin 3 (4): 10–11, doi:

- Shieber, Stuart M. (1994), "Lessons from a Restricted Turing Test", Communications of the ACM 37 (6): 70–78, doi:, Bibcode: 1994cmp.lg....4002S, http://www.eecs.harvard.edu/shieber/Biblio/Papers/loebner-rev-html/loebner-rev-html.html, retrieved on 25 March 2008

- Sterrett, S. G. (2000), "Turing's Two Test of Intelligence", Minds and Machines 10 (4): 541, doi: (reprinted in The Turing Test: The Elusive Standard of Artificial Intelligence edited by James H. Moor, Kluwer Academic 2003) ISBN 1-4020-1205-5

- Sundman, John (26 February 2003), "Artificial stupidity", Salon.com, Archived from the original on 7 March 2008, https://web.archive.org/web/20080307105346/http://dir.salon.com/story/tech/feature/2003/02/26/loebner_part_one/index.html, retrieved on 22 March 2008

- Thomas, Peter J. (1995), The Social and Interactional Dimensions of Human-Computer Interfaces, Cambridge University Press, ISBN 978-0-521-45302-8, https://archive.org/details/socialinteractio0000unse_b0z8

- Swirski, Peter (2000), Between Literature and Science: Poe, Lem, and Explorations in Aesthetics, Cognitive Science, and Literary Knowledge, McGill-Queen's University Press, ISBN 978-0-7735-2078-3

- Traiger, Saul (2000), "Making the Right Identification in the Turing Test", Minds and Machines 10 (4): 561, doi: (reprinted in The Turing Test: The Elusive Standard of Artificial Intelligence edited by James H. Moor, Kluwer Academic 2003) ISBN 1-4020-1205-5

- Turing, Alan (1948), "Machine Intelligence", in Copeland, B. Jack, The Essential Turing: The ideas that gave birth to the computer age, Oxford: Oxford University Press, ISBN 978-0-19-825080-7

- قالب:Turing 1950

- Turing, Alan (1952), "Can Automatic Calculating Machines be Said to Think?", in Copeland, B. Jack, The Essential Turing: The ideas that gave birth to the computer age, Oxford: Oxford University Press, ISBN 978-0-19-825080-7

- Zylberberg, A.; Calot, E. (2007), "Optimizing Lies in State Oriented Domains based on Genetic Algorithms", Proceedings VI Ibero-American Symposium on Software Engineering: 11–18, ISBN 978-9972-2885-1-7

- Weizenbaum, Joseph (January 1966), "ELIZA – A Computer Program For the Study of Natural Language Communication Between Man And Machine", Communications of the ACM 9 (1): 36–45, doi:

- Whitby, Blay (1996), "The Turing Test: AI's Biggest Blind Alley?", in Millican, Peter, Machines and Thought: The Legacy of Alan Turing, 1, Oxford University Press, pp. 53–62, ISBN 978-0-19-823876-8

Further reading

- Cohen, Paul R. (2006), "'If Not Turing's Test, Then What?", AI Magazine 26 (4), http://www.aaai.org/ojs/index.php/aimagazine/article/download/1849/1747.

- Marcus, Gary, "Am I Human?: Researchers need new ways to distinguish artificial intelligence from the natural kind", Scientific American, vol. 316, no. 3 (March 2017), pp. 58–63. Multiple tests of artificial-intelligence efficacy are needed because, "just as there is no single test of athletic prowess, there cannot be one ultimate test of intelligence." One such test, a "Construction Challenge", would test perception and physical action—"two important elements of intelligent behavior that were entirely absent from the original Turing test." Another proposal has been to give machines the same standardized tests of science and other disciplines that schoolchildren take. A so far insuperable stumbling block to artificial intelligence is an incapacity for reliable disambiguation. "[V]irtually every sentence [that people generate] is ambiguous, often in multiple ways." A prominent example is known as the "pronoun disambiguation problem": a machine has no way of determining to whom or what a pronoun in a sentence—such as "he", "she" or "it"—refers.

- Moor, James H. (2001), "The Status and Future of the Turing Test", Minds and Machines 11 (1): 77–93, doi:, ISSN 0924-6495, http://portal.acm.org/citation.cfm?id=596908.

- Warwick, Kevin and Shah, Huma (2016), "Turing's Imitation Game: Conversations with the Unknown", Cambridge University Press.

وصلات خارجية

- The Turing Test – an Opera by Julian Wagstaff

- اختبار تورنگ at the Open Directory Project

- The Turing Test – How accurate could the Turing test really be?

- قالب:Cite SEP

- Turing Test: 50 Years Later reviews a half-century of work on the Turing Test, from the vantage point of 2000.

- Bet between Kapor and Kurzweil, including detailed justifications of their respective positions.

- Why The Turing Test is AI's Biggest Blind Alley by Blay Witby

- Jabberwacky.com An AI chatterbot that learns from and imitates humans

- New York Times essays on machine intelligence part 1 and part 2

- قالب:Scientific American Frontiers

- Computer Science Unplugged teaching activity for the Turing test.

- Wiki News: "Talk:Computer professionals celebrate 10th birthday of A.L.I.C.E."

- مقالات بالمعرفة بحاجة لذكر رقم الصفحة بالمصدر from May 2011

- CS1 maint: bot: original URL status unknown

- Articles with dead external links from July 2018

- Short description is different from Wikidata

- Articles with hatnote templates targeting a nonexistent page

- Missing redirects

- EngvarB from June 2014

- Use dmy dates from June 2014

- Articles with unsourced statements from May 2011

- Turing tests

- Alan Turing

- Human–computer interaction

- History of artificial intelligence

- فلسفة الذكاء الاصطناعي

- 1950 in computing

- Computer-related introductions in 1950